El Big Data hace que la inteligencia artificial ya no sea ciencia ficción

Que el Big Data es ya el núcleo del Gobierno IT es algo perfectamente conocido, pero que las tecnologías de analítica cada vez se parecen más a cómo piensa el cerebro humano aún puede sonar a ciencia ficción. El proveedor de tecnología FICO lo ha explicado en una infografía, pero antes vamos a recordar alguna curiosa referencia cinematográfica.

La película Inteligencia Artificial de Steven Spielberg llevaba los procesos cognitivos humanos a los robots, pero entrando en el terreno de las emociones. Mucho antes de ello, el autor inicial de esa película, Stanley Kubrick, mostró en la mítica 2001: Una odisea del espacio, un robot mucho menos humano desde el punto de vista sentimental, pero mucho más parecido a lo que ahora entendemos por analítica, denominado HAL 9000.

Una leyenda urbana decía que HAL tomó su nombre de las letras alfabéticamente previas a las siglas del gigante de la informática IBM. Pero la realidad es que HAL es el acrónimo de Heuristically programmed ALgorithmic computer, que traducido al español es computador algorítmico heurísticamente programado. Es el principio de lo que se entiende por inteligencia artificial: La aplicación del funcionamiento analítico del cerebro humano a la computación, mediante métodos matemáticos.

Actualmente no hemos puesto aún el pie en Marte, pero tecnologías como Big Data, Bussiness Intelligence y la analítica hacen del Gobierno IT un proceso empresarial que, añadiendo la ventaja de la automatización y el cálculo masivo de datos en muy poco tiempo, cada vez se parece más a la forma de analizar del cerebro humano.

Esa es la conclusión a la que llega FICO en su informe, que asegura que el aumento de la robótica ha reflejado un auge en la inteligencia artificial (IA), y que el software analítico imita la manera de pensar de los seres humanos, o al menos lo que conocemos hasta ahora de la misma, ya que buena parte de nuestro cerebro sigue siendo un misterio. Para demostrar que esto no es ciencia ficción, FICO pone cuatro ejemplos:

Redes neuronales: Las neuronas en el cerebro almacenan conocimiento en sus conexiones con otras neuronas al tiempo que lo fortalecen con esa sinapsis. Esto inspira a las soluciones analíticas a la hora de detectar fraudes en los pagos, al crear conexiones entre los datos entrantes y resultados específicos, cambiando el “peso” de las conexiones para aprender la relación entre entradas y mejorar el rendimiento.

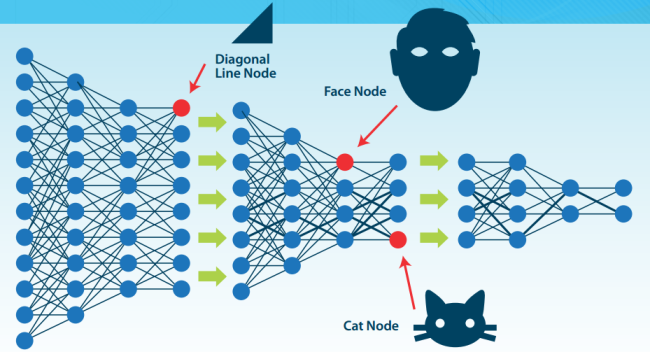

Redes profundas: Las neuronas del cerebro utilizan múltiples etapas de procesamiento en la corteza visual para aprender a reconocer las caras y clasificar objetos. Esto ha inspirado a las tecnologías de análisis de video y transcripción automática del habla, a través del procesamiento de bits de datos en múltiples capas.

Programación neurodinámica: El cerebro tiene un sistema de recompensa, que nos permite aprender secuencias de tareas complejas a través de las señales placenteras o dolorosas, que ocurren más tarde como consecuencia del acierto o error, respectivamente, en dichas tareas. Aunque a priori cueste creerlo, en esto se basan los agentes automatizados utilizados en las soluciones de gestión de reservas de viajes: Calculan el impacto del paso siguiente y todos los futuros pasos posibles, para evaluar continuamente el mejor paso siguiente con el que alcanzar el resultado deseado.

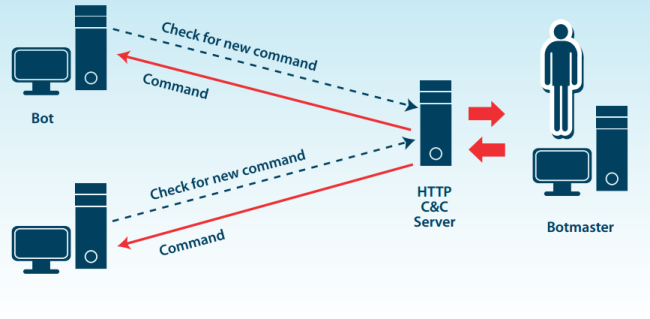

Ciberanalítica: Inspirado en cómo el cerebro controla el cuerpo y sus acciones a través de las sinapsis, las soluciones de seguridad identifican cuándo un malware ha tomado el control del PC. Para ello reconocen las relaciones de mando y control entre dos entidades diferentes, que son el PC infectado y el hostbot que lo controla.

Andrew Jennings, director de analítica en FICO y responsable de FICO Labs, explica que “con las nuevas teorías de los investigadores sobre cómo funciona el cerebro, los ingenieros de Big Data están incrementando sus capacidades y la velocidad que ofrecen las tecnologías para analizar datos”. Y va más allá con respecto a lo que nos espera en el futuro: “La combinación de las teorías de la neuropsicología para desarrollar soluciones sofisticadas de analítica nos permitirá encontrar respuestas a problemas hasta ahora irresolubles”.

La previsión que hace Jennings nos invita a volver al terreno de la ciencia ficción, y elucubrar acerca de las consecuencias futuras del Big Data, a medida que los procesos de analítica sean cada vez más sofisticados, también en términos de ética e incluso riesgos tal vez difíciles de controlar: ¿Llevará el Gobierno IT a decisiones tan estrictas y peligrosas como la de HAL 9000? ¿O conseguiremos una inteligencia artificial tan humana como la de los robots de Spielberg? Peor aún: ¿Cuál de las dos opciones puede llegar a ser más peligrosa?